博弘雲端在 AWS re:Invent 2025 搶先發佈技術文章後,技術特派今天將直擊由 AWS 代理式AI 副總裁 Dr. Swami 解析「代理式 AI (Agentic AI)」的未來!從週二 CEO Matt Garman 的議程當中可以看到 AWS 在形塑未來 AI 世界以強大的「代理行為」,重新定義AI的創新,而在 Dr. Swami 議程中,將會看到「具有自主權」的代理AI,如何改變技術發展的遊戲規則?

| TL;DR 博弘特派整理精華 – 代理式 AI 技術創新亮點 亮點一:開發階段的Strands Agents SDK 與模型驅動架構,降低維護成本 亮點二:Amazon SageMaker 三項 AI 新服務,免去企業維運基礎設施,專注模型客製 亮點三:Nova Act 與瀏覽器操作,如何打造專業級的「代理式艦隊」? |

目錄

目錄

代理式 AI是什麼?

代理式 AI (Agentic AI) 代表人工智慧從「被動生成內容」向「主動執行任務」的關鍵技術演進,不再只是依賴指令產出結果,而是具備推理規劃、記憶經驗及調用外部工具的能力,能針對模糊的目標自主拆解步驟,並採取行動以達成結果。

與AI 代理 (AI Agent) 的最大差別在於,代理式 AI 具備了代理權與自主權,能夠主動推理、規劃並採取行動來改變環境。換句話說,新的AI時代,是運用「代理式 AI」的技術思維與能力,來打造出能獨立解決問題的「AI 代理」。

從「對話」到「行動」:開發者的代理式AI自由新時代

「閉上眼睛,回想一下你第一次成功寫出程式的那一刻。那種『可以創造任何東西』的成就感與自由感,是每一位技術人的初衷。」在 AWS re:Invent 2025 的代理式AI未來主題演講中,Dr. Swami 以強而有力的故事開場,宣告了新時代的來臨:開發者不再受限於語法或繁瑣的 API 呼叫,代理式 AI 正在賦予開發者前所未有的「建構自由」。

過去幾年,我們對生成式 AI的對話能力感到驚艷;時至今日,我們更開始好奇,AI 如何替我們「做事」。在 AWS 代理式 AI未來的演講中,將透過介紹全新的 Strands SDK、Amazon Bedrock AgentCore 平台、神經符號 AI (Neurosymbolic AI) 以及 Nova Act等關鍵服務,全方位重塑智慧代理的開發、部署與信任機制!

開發階段:Strands Agents SDK 與模型驅動架構

傳統上,構建一個能執行複雜任務的 AI 應用,開發者需要編寫大量的「膠水程式碼 (Glue Code)」,硬編碼各種決策樹 (Decision Trees) 和狀態機 (State Machines)。這種方式脆弱且難以維護。但在今年五月,AWS 推出已開源的 Strands Agents SDK,代表「模型驅動」開發的未來。

- 自主編排:Strands 摒棄了預定義的工作流。開發者只需定義三個核心元件:模型、程式碼和 工具。現今的大型語言模型已經具備足夠的推理能力,能根據目標動態生成計畫並鏈接工具。

- 消除樣板代碼:根據AWS 內部數據顯示,使用 Strands 後,減少了數千行代理系統的程式碼,同時提高了準確性。

- 擴展性:AWS Strands Agents SDK新增支援 TypeScript,與邊緣設備,從雲端伺服器到機器人終端,工程師都可以迅速的規模化部署 Agent 都能流暢運行。

Strands Agents SDK 的價值在於大幅降低了維護成本。當業務邏輯變更時,不需要重寫複雜的狀態機,只需更新工具定義或 Prompt 上下文,模型會自適應新的路徑。

部署與維運:Amazon Bedrock AgentCore 破解「POC 監獄窘境」

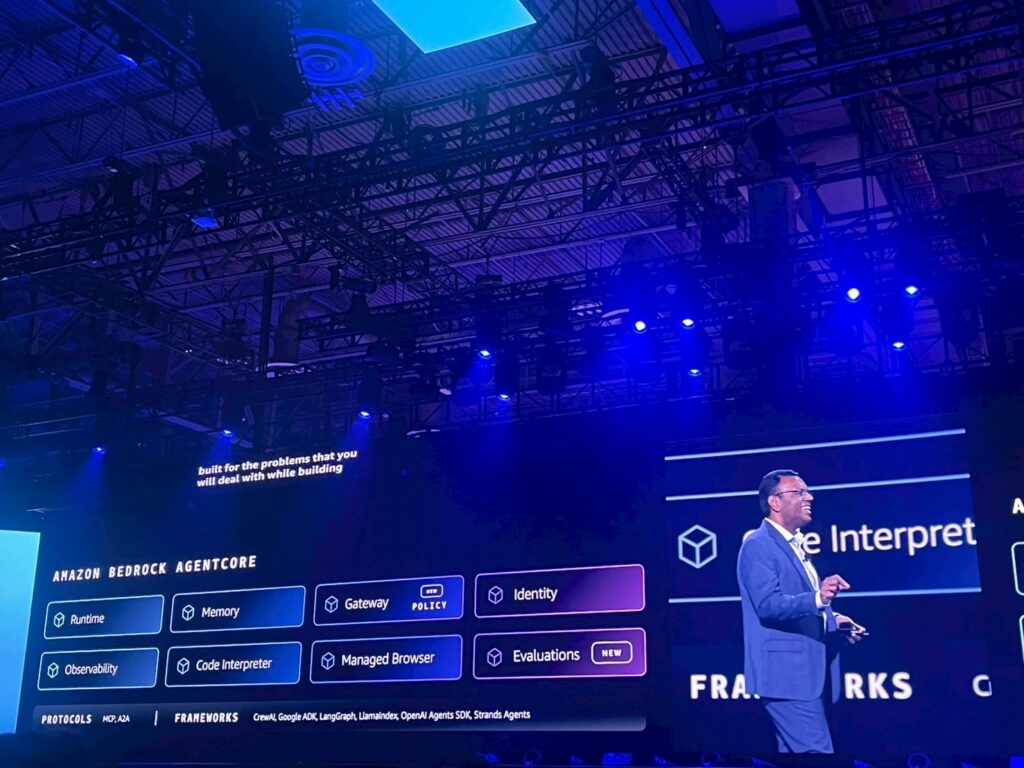

許多企業面臨的困境是,AI 代理在電腦上的 Demo 很完美,但一上線就崩潰,這就是所謂的「POC 監獄窘境」。生產環境需要的是並發處理、狀態隔離、持久記憶和嚴格的權限管理,因此在 CEO Keynote 當中分享的 Amazon Bedrock AgentCore 就是為了填補這個技術鴻溝。Dr. Swami 更進一步分享 Amazon Bedrock Agentcore的兩個全新功能:

1. 情節記憶 (Episodic Memory)

人的服務之所以貼心,是因為我們有記憶。Amazon Bedrock AgentCore 全新引入了情節記憶(Episodic Memory) 的功能,讓代理不僅有短期對話記憶,還能記住跨對話的長期偏好與特定事件,讓 Agent 從單純的指令執行者,進化為懂上下文的合作夥伴。

2. 身份與存取管理 (IAM) 的無縫整合

Amazon Bedrock AgentCore 內建了企業級的安全性。它能跨及 AWS 及第三方應用 Slack與Zoom等,處理複雜的認證流程。開發者不需要花數週時間編寫 OAuth 流程或處理 Token 更新,僅需幾行程式碼即可實現安全的工具調用。

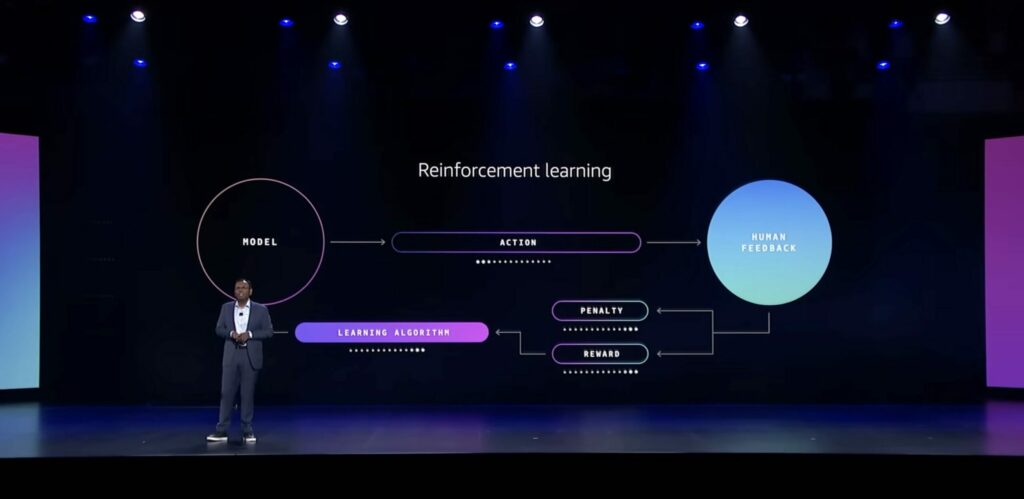

除此之外,為了讓 Agent 能夠規模化地迅速部署,AI模型的客製化將能夠平衡效率與 Agent 品質。然而為了提升 Agent 推論的能力,必須要有強化學習的指標判斷。但是強化學習的技術艱澀,且隨心所欲的客製化可能讓企業難以負擔高額成本。因此,AWS在 Amazon Bedrock 中引入了 Reinforcement Fine-Tuning (RFT) 技術,自動化高階模型的客製化流程,讓模型能夠透過學習結果來提高準確性,最重要的是企業無需具備深厚的機器學習專業知識即可使用。

Amazon SageMaker AI 新服務 免去基礎設施維運

Dr. Swami 在今年的 AWS re:Invent 中提到三項 Amazon SageMaker AI 服務的更新,讓模型的部署變得更簡單:

- SageMaker AI 模型客製化套件 SageMaker AI 提供了更全面的工具,來建構獨特的 AI 模型,包括監督式微調 (Supervised Fine-tuning)、模型蒸餾 (Model Distillation) 以及直接偏好最佳化 (Direct Preference Optimization)。

- SageMaker AI 無伺服器模型客製化 (Serverless Model Customization) ,簡化時下流行AI模型的客製化過程。透過內建的「AI 專家代理」引導,工作流程得以大幅精簡,將原本需要數個月的開發時間縮短至僅需數天。

- SageMaker HyperPod Checkpointless Training 針對大規模訓練的效率問題,推出無檢查點訓練功能。透過在分佈式叢集中連續保存模型狀態,降低訓練期間的恢復開銷支出,不僅能實現更快的故障恢復,還能大幅節省運算成本。

- Nova Forge 針對需要構建自定義 Frontier models的企業,提供成本效益的方案。允許企業利用 Amazon Nova,在訓練的中期循環中整合專有數據,打造專屬的高效能模型。

神經符號AI的信任與可靠性,如何讓AI更合規?

隨著 Agent 權限越來越大,像是能夠自動處理金流,或是修改生產環境配置,企業該如何信任它們不會出現幻覺?在議程中 AWS 科學家 Byron Cook 受邀上台簡介,如何有邏輯地運用演算法驗證或反駁 AI 系統的行為。當正式的推理結合大型語言模型,神經符號 AI (Neurosymbolic AI) 的概念就順勢出爐。神經符號 AI (Neurosymbolic AI) 是 AWS 解決代理信任危機的關鍵技術,它將 LLM 的「統計創意」與自動推理的「數學邏輯」結合,賦予 AI 數學上可被證明的正確性。

- 事前教育: 利用定理證明器(如 Lean)生成邏輯嚴謹的數據來訓練模型,從源頭提升推理能力。

- 事中監督: 在推論當下嵌入 Sidecar 驗證器,即時依據邏輯約束攔截並修正錯誤 Token。

- 事後驗證: 對生成結果進行邏輯簽核,若未通過則強制回饋重試,形成閉環修正。

這讓企業能以數學邏輯鎖定 AI 行為,確保 Agent 在處理關鍵任務時既具備彈性,又絕對安全合規。AWS 有兩種實踐方式:

- AWS Kiro IDE 的規格驅動開發: Kiro 不僅生成代碼,還會根據自然語言生成「規格」。利用自動推理技術來驗證生成的程式碼是否數學上符合這些規格,並自動生成邊界測試案例。

- Amazon Bedrock AgentCore Policy 與 Cedar 語言: 企業可以用自然語言定義策略,像是禁止代理在生產環境執行 Update 操作;系統系統會將其轉換為 Cedar語言。在推論階段 ,有一個「側車 (Sidecar)」驗證器會即時檢查 LLM 的輸出,如果 LLM 試圖違規,驗證器會強制修正其行為。

自動化的最後一哩路:Nova Act 與瀏覽器操作

企業中有大量的工作流是發生在瀏覽器介面 (UI) 上的,且沒有 API 可用。但在自動化的演進史上,一直面臨著兩難的局面。

從 RPA 的「脆弱」到 LLM 的「盲目」

回顧 2000 年代,我們依賴機器人流程自動化(RPA)來填補遺留系統的缺口。RPA 能模擬點擊,但它極度脆弱,使用者介面只要稍有變動,腳本就會崩潰。隨後 LLM 的出現帶來了轉機,它們能理解 UI 變化並適應複雜性,卻帶來了新的噩夢:編排 (Orchestration)。

與傳統腳本「一錯即停」不同,LLM 可能在錯誤的路徑上繼續執行數週才被發現,缺乏有效的錯誤處理與回溯機制,使得大規模使用 LLM 進行電腦操作變得昂貴且風險極高。企業真正需要的是高可靠性,不只是做對一次,而是能成千上萬次穩定地重複執行。

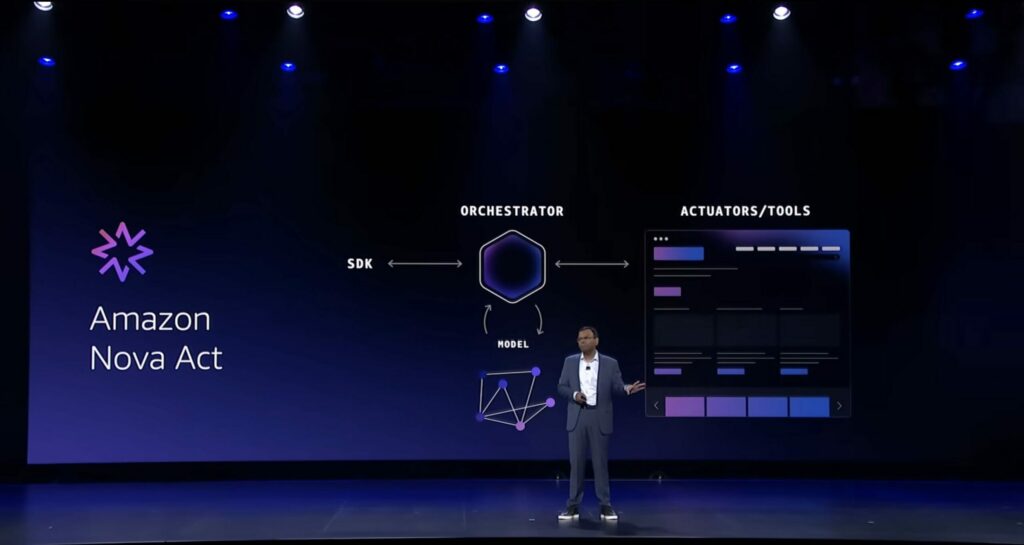

Nova Act:完整的自動化服務

為了讓自動化變得簡單且可靠,AWS 正式宣布 Amazon Nova Act 的新服務。Nova Act 不僅是一個更好的模型,更是一個緊密整合的端到端服務,專為構建和管理生產級的 「代理艦隊 (Fleets of Agents)」 而生。

- 垂直整合打破「缸中之腦」困境: 傳統做法是將訓練好的模型外掛到瀏覽器工具上,而Nova Act 則是採用端到端後訓練 (End-to-End Post-Training),模型在訓練時就已經與編排器 (Orchestrator) 和操作器 (Actuators) 緊密結合,確保模型天生就懂得如何與瀏覽器互動。

- 強化學習健身房 (RL Gyms): AWS 建立了數百個模擬企業環境(像是CRM與HR 系統)的「健身房」,讓 Agent 在其中透過數十萬次的試錯 (Trial and Error) 學習。

憑藉從模型到執行層的深度優化,Nova Act 在企業工作流設置中達到了 90% 的可靠性。它解決了傳統 LLM 自動化「不知錯、不能改」的問題,提供最快的價值實現時間與規模化能力。

Dr. Swami 在結尾時提到:「真正的效率不是靜態的自動化,而是動態的適應。」代理式 AI 的崛起,不是為了取代人類,而是為了消除繁瑣,讓企業能專注於那些「只有人類能做」的創新。 從 Strands 的開發簡化,到 Amazon Bedrock AgentCore 的生產級防護,再到 Neurosymbolic AI 的信任機制,AWS re:Invent 的議程中用代理式AI的未來貫穿AI技術的未來發展!

代理式AI在未來還有哪些新應用?立即加入博弘雲端電子報,掌握前瞻的 AI與雲端技術趨勢!