AI 徹底改變了我們的生活、工作與查找資訊的習慣,但是,AI 運算所需的基礎設施,也得全面升級,才能夠支撐起全球每天數億次的 AI 應用。博弘雲端 Live From Vegas 第三彈,要來解密 AWS re:Invent 當中發布的黑科技,從自研晶片、無伺服器的管理再到AI基礎設施的全新面貌,賦予未來企業在AI應用上有更多的可能性。

AWS 公用運算高級副總裁 Peter DeSantis 在演講開場即強調,儘管 AI 正在推動應用程式的轉型,但雲端的核心價值—安全性、可用性、彈性、成本與敏捷性,在 AI 時代反而變得更加重要,今天全新發佈的解決方案正是回應這些核心需求。透過現場直播的精華,博弘雲端技術特派員替各位整理出 Peter DeSantis 與 Dave Brown 演講的技術革新與全新AI基礎設施亮點!

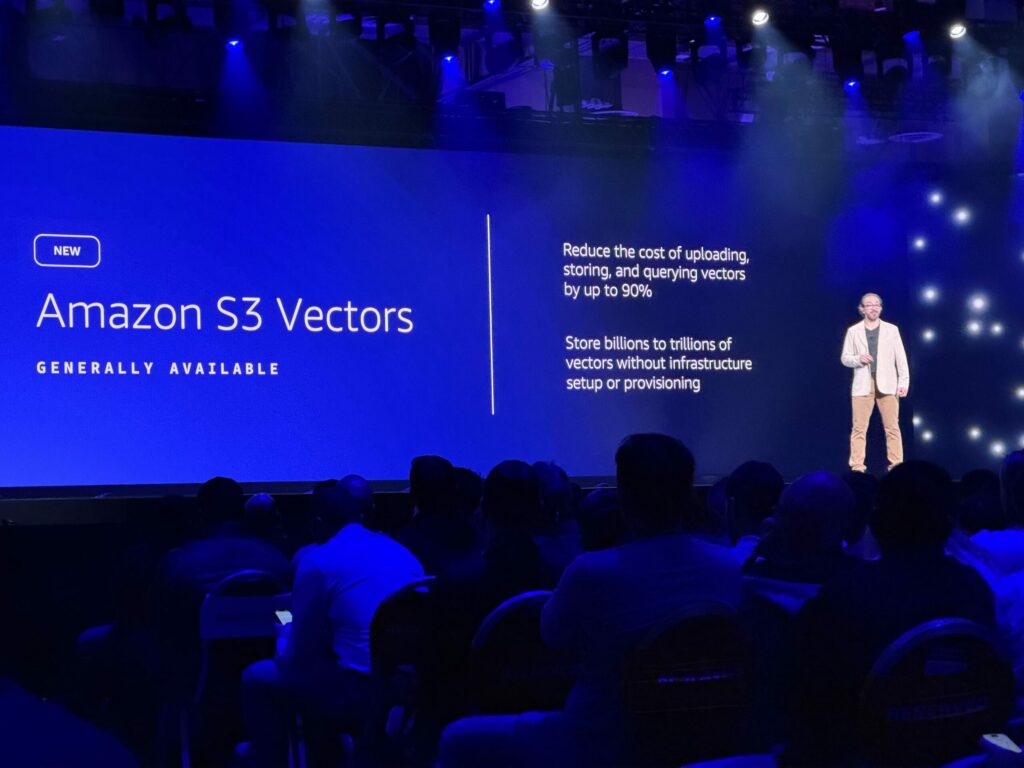

| TL;DR 博弘特派整理 – AI 基礎設施創新亮點: 亮點一:算力性價比之王-Graviton 5 登場,單一封裝 192 核心,資料庫效能暴增 60%,Apple 實證遷移至 ARM 架構可省下 30% 成本。 亮點二:AI 資料檢索革命-Amazon S3 Vectors 讓 S3 直接變身向量資料庫,無需搬移資料即可對十億級別的檔案進行毫秒級語意搜尋。 亮點三:開發門檻歸零-Trainium 晶片正式支援 PyTorch Native,開發者只需改一行程式碼即可享受比 GPU 低 40% 的訓練成本。 |

目錄

目錄

自研晶片再突破—AWS Graviton5 強勢登場

如果說 AWS Nitro System 改變了雲端基礎設施的各種可能性,讓 AWS 能夠在其中運行多個 Amazo EC2執行個體,那麼AWS自行研發的 Graviton 晶片則重新定義了雲端運算的性價比。

企業在 AI 應用上,運作著龐大的資料庫或高流量的微服務,Graviton5 絕對是必須關注的升級。在本次演講中,AWS 運算與機器學習服務副總裁 Dave Brown 在台上強調,AWS 不只是造晶片,而是從晶片到冷卻系統的全面革新。全新的 Graviton5 在單一 CPU 封裝中塞入了 192 個核心,並解決了前一代核心間爭奪記憶體資源的問題,將 L3 Cache 提升了 5 倍以上。

搭載 Graviton5 的 Amazon EC2

搭載 Graviton5 的 Amazon EC2 M9g 執行個體也隨之問世,相較於 M8g 提升了 25% 的效能,同時提供運算與後端開發上更好的性價比。以 SAP 為例,SAP Hana 中以線上交易處理(OLTP)記憶體密集型的資料庫應用,用Graviton提升 60% 效能。

Apple 的 Graviton 應用實戰

Apple 的雲端系統副總裁 Payam Mirrashidi 分享將其後端服務從 x86 架構遷移至 Graviton,並使用 Swift 語言開發伺服器端應用。其中,在實際案例中,iOS 簡訊的垃圾訊息偵測功能需要處理數十億的請求,並使用同態加密(Homomorphic Encryption)來保護隱私。透過 Graviton 與 Swift 的結合,Apple 實現增加 40% 的效能與降低 30% 的成本。

無伺服器的新定義—AWS Lambda Managed Instances

多年前,當AI技術還尚未普及時,開發人員好奇,如果把程式碼交給AWS讓其運行,且不用再管理伺服器邏輯、運算資源的編碼,是否會增加開發效率?除此之外,當工程師想要自動化應用程式所伴隨來的的資料庫事件、Log系統與API呼叫等工作流,達到「無伺服器」的最佳狀態時,是否有相對應的解決方案?

過去十年,AWS Lambda 就是解答,它代表著「無伺服器」解決方案。但有時開發者需要 EC2 的GPU 或特定運算資源的硬體選擇權,卻不想管理伺服器。因此,在本次 AWS re:Invent 大會上,AWS Lambda Managed Instances 就隨之誕生,提供新一代進化的無伺服器運算。

AWS Lambda 新應用模式:

現在起,工程師可以指定 AWS Lambda 運行在特定的 Amazon EC2 執行個體上。AWS 負責修補與擴展伺服器的基礎設施,工程師只需負責寫程式碼,實現「無須管理伺服器」的Serverless 最佳狀態。

現有 AWS Lambda 函式無痛轉移:

最重要的是,完全不需要重寫現有的 AWS Lambda 程式碼與函式,開發團隊即可直接享受 Amazon EC2 的硬體效能。對於影片處理、機器學習預處理等需要長時間運算,或特殊硬體加速的無伺服器應用,打開了全新契機。

Amazon Bedrock 新推論引擎 Project Mantle

隨著生成式 AI 進入生產環境,企業發現「推論(Inference)」的成本與擴展性是一個巨大的挑戰。AI 推論不僅昂貴,而且需求波動極大。舉例來說,當今天有大型推論需求,且需要長時間營運時,可能就會造成穩定性與算力成本的壓力。因此,AWS 重新設計了 Amazon Bedrock 的底層推論引擎 Project Mantle,讓企業能輕鬆自如地針對不同應用管理 AI 算力。

服務分級 (Service Tiers):

並不是所有推論都有同樣的延遲緊急性需求,因此企業不再需要將效能割捨給其他非緊急的推論工作。Amazon Bedrock 現在開放將請求分為三個等級:Priority 用於即時互動、Standard 用於穩定負載,以及 Flex 通道適合背景任務且效率優先,用於重視成本大於速度的批次作業,確保每個推論作業都能得到應有的資源。

推論列隊隔離與公平性:

每個客戶都擁有獨立的佇列,一個客戶的突發情況不會影響其他客戶效能。透過隊列隔離技術與彈性的推論量能空間,Amazon Bedrock Project Mantle 確保客戶的使用不會影響到其他人的推論工作,同時也能夠根據應用狀況優化效能。

Journal 交易日誌:

Amazon Bedrock Project Mantle 引入了Amazon DynamoBD 資料庫「Journal 交易日誌」的概念, 為 AI 工程師解決模型微調穩定性的難題。Journal 運作如同高可靠的交易日誌,能即時保存 Request 執行狀態。一旦發生故障或需讓位給高優先級的即時推論流量,系統無需耗時重啟,即可實現「斷點續傳」。這種動態排程能力,不僅大幅降低算力浪費,更讓模型訓練與即時服務能高效共存,提升 LLM 架構的容錯率與資源利用率。

資料即向量—Amazon S3 Vectors 搜索

對於擁有海量資料的企業來說,要即時找出合適且所需的資料進行訓練有一定的難度。除此之外,不同的資料類型需要有合適的嵌入模型 (Embedding Models),但無法跨模組做共同搜尋,也會讓企業耗費龐大的時間。在檢索增強生成(RAG)架構中,將非結構化資料轉為向量是必經之路。但建立與維護一個高效的向量資料庫非常昂貴且複雜。種種挑戰,也讓企業在資料運用的過程中受到阻礙。

時至今日,AWS 的多項服務中已經有廣泛的向量應用。而今天在 AWS re:Invent 大會上更深入宣布 Amazon S3 Vectors 向量資料庫的搜索能力,打破效能與成本的取捨,讓資料原地升級,無痛遷移,輕鬆利用生成式 AI 活化內部知識庫:

Amazon S3 即向量資料庫:

企業無需再將資料搬移到外部資料庫,直接在現有的 Amazon S3 儲存桶中即可建立向量索引。無需重新架構基礎設施,原先儲存的影片、文件與圖片檔案的地方,現在也是您的向量資料庫,且具備 Amazon S3 同等級的持久性與擴展性保證。

Vector Neighborhoods如何運用:

為了在 Amazon S3 在物件儲存上實現高效搜尋,AWS 預先計算了「向量鄰里 (Vector Neighborhoods)」。當查詢發生時,系統只需載入相關的鄰里資料到記憶體中,讓 Amazon S3 Vectors 能在 20 億個向量的規模下,實現 100 毫秒以內的查詢速度。

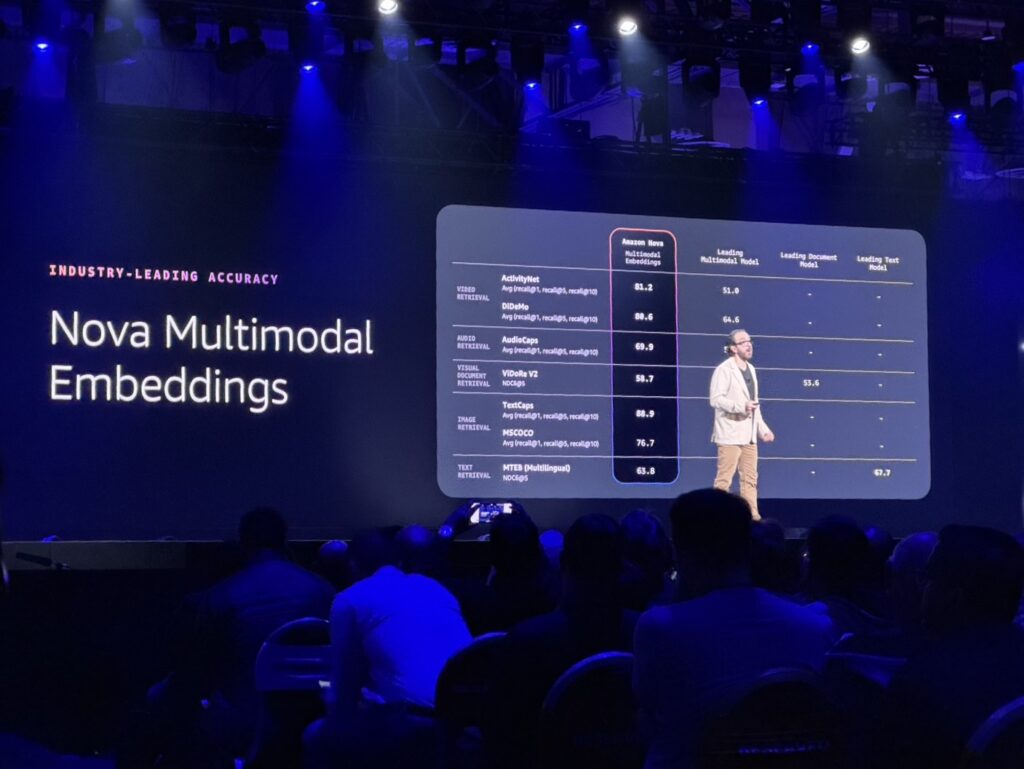

多模態嵌入模型整合:

搭配新的 Amazon Nova Multimodal Embeddings 模型,企業可以將文字、影像、音訊轉換為統一的向量空間,實現跨模態的搜尋。

AI 算力軍備競賽—Trainium3 與 UltraServers

隨著生成式 AI 工作負載呈爆炸性增長,算力成本與能源效率成為 AI 工程師面臨的最大挑戰,AWS 推出的 Trainium3 晶片與第二代 UltraServer 架構正是為了解決運算效能效率的瓶頸。Trainium3 不僅支援從稠密 Transformer、混合專家模型 (MoE) 到狀態空間模型 (SSM) 等各類先進架構,更將訓練與推論的性價比推向新高,預計能比現行方案降低高達 40% 的成本。

在硬體規格上,新一代 Amazon EC2 Trn3 UltraServers 將 144 顆 Trainium3 晶片整合於單一系統,透過專用的 Neuron Switches 實現極低延遲的互連,提供驚人的 360 PetaFLOPS (8-bit) 算力與 20TB 的高頻寬記憶體 (HBM),頻寬更高達 700TB/s,是構建 AI 超級電腦的基礎。

從系統設計角度來看,AWS 採用了獨特的伺服器設計,直接將 Graviton 處理器與 Trainium 加速器整合於同一塊電路板上,不僅消除傳統架構中對獨立 Head Node 的需求,更透過 Nitro 卡支援 EFA (Elastic Fabric Adapter) 實現千點規模的記憶體共享與容錯機制。

另外,在軟體生態方面,AWS 深刻理解開發者的痛點,宣布 Trainium 全面支援 PyTorch Native,工程師只需將程式碼中的 .to(‘cuda’) 改為 .to(‘neuron’) 即可無痛遷移。對於追求極致效能的開發者,AWS 開放了 NKI (Neuron Kernel Interface) 與硬體級 Profiler,允許在 Python 環境中直接調度底層指令並視覺化瓶頸,且不影響運行效能。Trainium3 在維持相同延遲的情況下,實現了每百萬瓦輸出 Token 數提升 5 倍的能源效率,為高強度的 AI 模型訓練與即時推論提供了兼具高效能與可維護性的最佳解方。

企業如何在 AI 應用上達成更好成效?

Peter DeSantis 與 Dave Brown 的演講精華在於,AI 的浪潮下,基礎設施的基本功如安全性、彈性與成本,依然是決勝關鍵。無論是透過 Graviton5 降低傳統運算成本、利用 AWS Lambda Managed Instances 提升開發靈活性,或是透過 Trainium3 與 S3 Vectors 解決 AI 時代最頭痛的算力與資料問題,AWS 都在基礎設施上做足了準備。

而針對企業在未來考量 AI 應用的運算能力、硬體設備與效能評估上,提供三大技術建議:

評估 Graviton 遷移:

隨著 Graviton5 的問世,性價比優勢更加明顯,建議檢視非 x86 依賴的工作負載進行遷移。

善用 Amazon Bedrock 新功能:

若您考慮建立生成式 AI應用,Amazon Bedrock 的新分級服務能有效幫助您控管推論成本。

評估 Amazon S3 Vectors:

若您擁有大量非結構化資料,Amazon S3 Vectors 提供了一條無需建立複雜向量資料庫的 RAG 捷徑。

想了解更多關於 AWS 新服務如何應用在您的架構中嗎?立即訂閱博弘雲端電子報,為您帶來的 AWS re:Invent 最即時的技術分析!